搜索引擎Spider的工作原理剖析(揭秘Spider如何爬行网站)

![]() 游客

2024-08-31 12:50:01

181

游客

2024-08-31 12:50:01

181

随着互联网技术的不断发展,搜索引擎已成为人们获取信息的主要渠道,而搜索引擎中的Spider(蜘蛛)则是其核心组成部分之一。Spider是如何工作的呢?下面将从工作原理、爬行网站等方面详细介绍。

1、Spider的定义和作用

Spider是搜索引擎中的程序,其作用是通过网络爬行(即访问)互联网上的网页,并按照一定规则收集、存储相关数据,以便于后续处理和使用。

2、Spider的爬行路径

Spider的爬行路径通常是从一个特定的起始点(如某个特定网址)开始,然后沿着页面中的链接或其他指向其他页面的方式不断地访问下去,直到遍历完所有可访问到的页面。

3、Spider的爬行深度

Spider的爬行深度取决于其所设置的参数,一般来说,深度越深,获得的数据也就越全面,但相应地,访问时间和网络资源消耗也会增加。

4、Spider的工作流程

Spider的工作流程主要包括四个步骤:发送请求、解析页面、处理数据和存储数据。具体而言,Spider首先向服务器发送请求,获取HTML页面源代码,然后解析页面并提取有用信息,接着对信息进行处理和存储。

5、Spider的抓取方式

Spider的抓取方式有两种:广度优先和深度优先。广度优先是指从起始点开始,依次访问其周围所有链接,直到将所有链接都访问一遍;深度优先则是从起始点开始,依次访问链接所指向的下一个页面,直到遍历完整个网站。

6、Spider的数据解析

Spider获取到的HTML代码需要进行解析,以便于提取有用的信息。常用的数据解析技术包括正则表达式、XPath、CSS选择器等。

7、Spider的数据处理

Spider获取到的数据需要经过处理才能被使用。数据处理包括去重、筛选、格式化等多个步骤,以确保数据的准确性和可用性。

8、Spider的存储方式

Spider获取到的数据需要存储起来以便后续使用。常见的存储方式有文本文件、数据库等。

9、Spider的重要性

Spider是搜索引擎中不可或缺的一环,它通过爬行整个网络获取数据,为搜索引擎提供了强有力的支持。

10、Spider的工作原理

Spider的工作原理主要是通过网络爬行(即访问)互联网上的网页,然后对页面进行解析和处理,最终存储相关数据。

11、Spider的挑战与解决

Spider在爬行过程中遇到的挑战包括:反爬虫技术、网站限制等。为了解决这些问题,Spider需要使用一些技术手段,如伪装浏览器、使用代理等。

12、Spider的应用领域

Spider广泛应用于搜索引擎、数据挖掘、网络安全等领域。有些企业会使用Spider来爬取竞争对手的数据以了解市场动态。

13、Spider的未来发展

随着互联网技术的不断发展,Spider也在不断地更新迭代,未来将更加智能化、自适应、个性化,为人们提供更加便捷、准确的搜索服务。

14、Spider的合法性

虽然Spider的工作原理有些像黑客攻击,但是合法的Spider并不会对网站造成实质性的危害,且其目的是为了为搜索引擎提供更好的搜索结果和用户体验。

15、

综上所述,Spider是搜索引擎中非常重要的一部分,其工作原理主要是通过爬行网络,解析页面,处理数据,最终存储相关数据。同时,Spider在应用领域也非常广泛,未来发展潜力巨大。

搜索引擎Spider的工作原理

随着互联网的发展,搜索引擎成为我们获取信息的主要途径。而搜索引擎中的Spider是负责收集网页信息的重要组成部分,了解其工作原理对于我们使用搜索引擎有很大的帮助。

一、Spider的定义与分类

Spider是指一种自动化程序,通过互联网搜集信息并建立索引,以便于用户搜索时能够快速找到相关信息。根据其工作方式不同,可以将Spider分为深度优先和广度优先两种类型。

二、Spider的基本流程

Spider的基本流程包括:识别种子URL、抓取网页、解析网页、存储数据和更新索引。具体来说,Spider会从种子URL开始访问网页,再逐级深入抓取网页中包含的链接和内容,并将有价值的信息存储起来。

三、URL去重策略

在抓取过程中,Spider需要避免重复抓取同一URL,以节约时间和资源。常见的去重策略包括:哈希算法、布隆过滤器和数据库去重等。

四、页面抓取策略

Spider需要根据网页的结构和特点来制定抓取策略,以确保尽可能多地抓取有用信息。常见的页面抓取策略包括:广度优先、深度优先和PageRank算法等。

五、页面解析策略

Spider在抓取页面后需要对其进行解析,以提取有价值的信息。页面解析策略包括:正则表达式、XPath和CSSSelector等。

六、数据存储与索引

Spider抓取到的数据需要进行存储和索引,以便于用户搜索时能够快速找到相关信息。常见的数据存储方式包括:关系型数据库和NoSQL数据库等。

七、Spider的调度

Spider需要根据调度策略来确定抓取哪些网页,以及何时进行抓取。常见的调度策略包括:时间调度和优先级调度等。

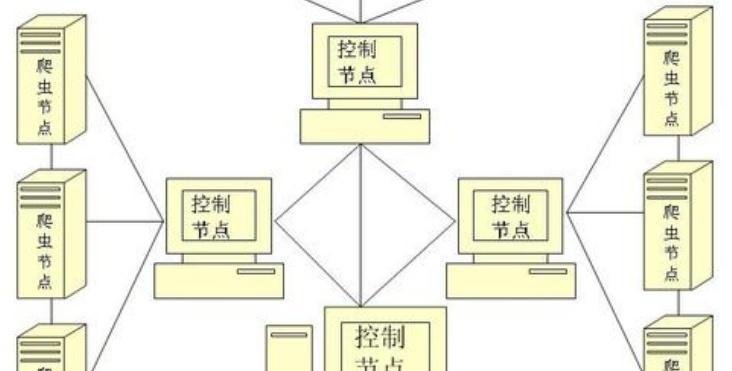

八、Spider的并发控制

Spider需要进行并发控制,以保证多个Spider之间不会相互干扰或抢占资源。常见的并发控制方式包括:线程池和分布式架构等。

九、反爬虫机制

为了防止Spider对网站造成过大的访问负荷或进行恶意攻击,网站会采取反爬虫机制进行防御。常见的反爬虫机制包括:IP限制、验证码和登录限制等。

十、Spider的优化

Spider的优化可以提高其抓取效率和准确率,从而提高搜索引擎的服务质量。常见的Spider优化方式包括:并发优化、缓存优化和算法优化等。

十一、Spider的发展趋势

随着互联网技术的不断发展和应用场景的不断扩大,Spider也在不断演化。未来Spider的发展趋势包括:大数据技术的应用、深度学习算法的运用和智能化的发展方向。

十二、Spider与搜索引擎的关系

Spider是搜索引擎的重要组成部分,负责收集并建立网页索引,为用户提供更加精准、快速的搜索服务。搜索引擎的效率和准确性都与Spider的运行效果息息相关。

十三、Spider的应用场景

除了在搜索引擎中广泛应用外,Spider还可以在数据挖掘、竞品分析和网络监测等领域发挥重要作用,为企业和用户提供更多有价值的信息和服务。

十四、Spider的局限性与挑战

Spider在收集信息方面存在一些局限性,如无法收集动态生成的网页、无法识别图片和视频等。Spider还面临着反爬虫机制和隐私保护等挑战。

十五、

Spider作为搜索引擎的重要组成部分,扮演着收集、处理和索引网页信息的重要角色。了解Spider的工作原理,可以帮助我们更好地理解和使用搜索引擎,同时也为我们学习和研究相关技术提供了基础。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自168seo,本文标题:《搜索引擎Spider的工作原理剖析(揭秘Spider如何爬行网站)》

标签:SEO优化

- 搜索

- 最新文章

- 热门文章

-

- 关键词是什么意思?关键词在SEO中扮演什么角色?

- 如何提升搜索引擎优化排名seo?

- 设计灵感网站如何激发创意?

- ae素材网站有哪些?如何找到高质量的ae素材?

- seo优化工具有哪些?如何选择适合自己的?

- ppt模板免费下载网站哪里找?如何挑选高质量模板?

- seo网站制作需要注意哪些要点?

- bi哔哩哔哩.官网怎么登录?登录后有哪些功能?

- bi哔哩哔哩.官网有哪些特色功能?如何有效利用站长工具、?

- 网站制作中如何实现良好的用户体验?

- 设计网站如何吸引用户?设计网站有哪些成功案例?

- 网站模板如何选择?免费模板和付费模板的区别是什么?

- 网站专业建设的标准是什么?如何进行网站专业建设?

- 快速网站关键词排名的技巧是什么?

- 个人网站建设如何选择模板?模板的选择标准是什么?

- 建设网站时如何优化SEO?

- 专业的网站建设需要哪些步骤?如何选择一家专业的网站建设公司?

- 平面设计网站如何选择?如何利用这些网站提高设计水平?

- 关键词快速排名软件有效吗?如何选择?

- 毕业设计网站如何使用?有哪些资源?

- 热门tag

- 标签列表

- 友情链接