中小企业如何高效突破反爬限制进行数据采集?

![]() 游客

2025-04-19 15:52:01

6

游客

2025-04-19 15:52:01

6

在数字化时代,数据已成为企业竞争的重要资源。中小企业在运营过程中,常常需要采集外部数据以支持决策、市场分析和产品优化。然而,许多网站通过设置反爬虫机制来保护其数据,这对数据采集工作带来了挑战。本文将为中小企业提供高效突破反爬限制进行数据采集的方法和策略,帮助企业在合法合规的前提下实现数据资源的有效获取。

一、理解反爬机制及合法性考量

在深入研究突破反爬的方法之前,首先需要了解反爬机制的种类和基本原理。网站可能通过以下手段限制爬虫访问:

IP限制:通过限制单一IP地址在一定时间内的请求次数。

用户代理(UserAgent)检测:识别访问者是否为常规浏览器。

动态验证码:在用户请求时要求输入验证码以证明其为人操作。

Cookie追踪:追踪用户行为,识别重复访问行为。

JavaScript渲染:动态加载数据,使传统爬虫难以解析。

在突破反爬限制之前,企业必须确保其行为符合相关法律法规。违反网站服务条款或当地法律将导致严重的法律后果。建议中小企业通过合法途径进行数据采集,例如使用公开的API服务或直接联系网站管理员获取许可。

二、采用合法爬虫技术突破反爬

1.IP代理池的使用

为了避免IP被封禁,可以使用IP代理池。通过不断更换IP地址,降低被识别为爬虫的风险。在选择代理服务时,确保其可靠性和稳定性,并注意遵循使用条款,避免使用可能涉及非法活动的代理。

2.高级爬虫框架的应用

使用如Scrapy、Selenium等高级爬虫框架能够模拟真实用户行为,处理JavaScript渲染和验证码等反爬措施。Selenium可以驱动浏览器执行JavaScript,获取动态生成的内容。

3.自然行为模拟

模拟正常用户的浏览行为,如页面停留时间、访问频率等,可降低被反爬系统检测到的可能性。可以采用定时等待(如使用`time.sleep()`)和随机化访问模式来实现。

4.多用户代理轮换

通过轮换不同的用户代理字符串,可以避免被网站通过User-Agent检测来识别爬虫。可以定期更新和更换用户代理列表,以模拟不同类型的浏览器。

三、数据采集过程中的注意事项

1.尊重robots.txt协议

大多数网站会有一个名为robots.txt的文件,其中指明了哪些内容可以被爬取,哪些不可以。始终遵守这一标准是获取数据的前提。

2.缓存和存储策略

合理设置缓存策略,减少对目标网站的请求频率。同时,应合理规划数据存储结构,方便后续的数据分析和使用。

3.异常处理和日志记录

在数据采集过程中,应设置异常处理机制,并记录日志,以便于问题的快速定位和解决。

四、处理反爬限制的高级策略

1.CAPTCHA识别技术

对于验证码问题,可以使用OCR(OpticalCharacterRecognition)技术或第三方验证码识别服务进行处理。但需注意,某些类型的验证码可能涉及版权或隐私问题,使用时需要特别小心。

2.多线程与异步请求

通过多线程或异步请求来提高爬虫效率,并有效模拟多用户访问模式。但要注意线程安全和请求频率的控制,避免给目标网站带来过大压力。

3.云服务与分布式爬虫

使用云服务和分布式爬虫架构可以实现资源的弹性扩展,有效应对大规模的数据采集需求。这同样需要确保合法合规使用云服务提供商的服务。

五、数据分析与应用

数据采集不是终点,而是数据分析与应用的起点。企业需要对采集来的数据进行清洗、整理、分析,并转化为实际可行的商业策略。

六、结语

中小企业在进行数据采集时,应注重合法合规性,并采取有效策略突破反爬限制。通过理解反爬机制、使用合法技术手段、注意采集过程中的细节处理,企业可以高效且安全地获取所需数据。最终,这些数据将为企业的决策提供有力支撑,帮助企业在激烈的市场竞争中脱颖而出。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自168seo,本文标题:《中小企业如何高效突破反爬限制进行数据采集?》

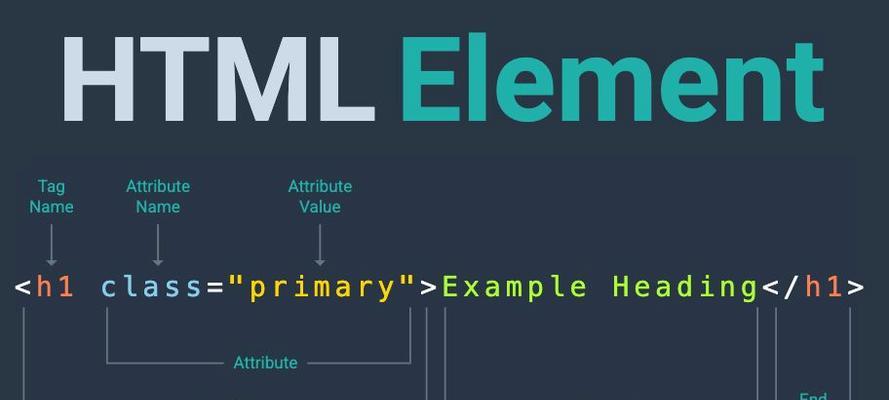

标签:HTML元素

- 上一篇: 如何判断SEO服务商是否过时?

- 下一篇: 如何关闭华为搜索引擎?有无替代方案?

- 搜索

- 最新文章

- 热门文章

-

- 网站建设的常见问题有哪些?如何解决这些问题?

- 济南网站建设的费用是多少?如何选择合适的公司?

- SEO优化还有用吗?2024年SEO策略如何调整?

- SEO搜索排名优化的有效策略有哪些?

- 大连网站制作流程是什么?如何选择大连网站制作公司?

- 网站过度优化有哪些迹象?七大表现告诉你答案!

- 怎样提高优化关键词的密度?有效策略有哪些?

- 企业网站seo优化的常见误区有哪些?如何正确进行优化?

- 如何通过企业网站设计提升用户体验?

- 企业网站建设设计中应重视哪些要点?

- 企业网站设计服务中如何实现个性化定制?有哪些策略?

- 深圳手机网站建设的注意事项有哪些?

- 企业网站模板应该如何选择?有哪些推荐的模板?

- 当前网站设计的最新趋势有哪些?

- 个人建设网站制作需要注意什么?个人网站建设的要点有哪些?

- 提升关键词seo排名有哪些技巧?

- 个人怎么做网站才能提高用户体验?用户体验优化方法有哪些?

- SEO怎么优化关键词?最佳实践是什么?

- seo快排是什么意思?如何实现?

- 上海seo优化如何应对百度算法更新?有哪些应对策略?

- 热门tag

- 标签列表

- 友情链接