解析百度搜索引擎蜘蛛的工作原理(从爬行到索引)

![]() 游客

2024-03-14 10:50:02

151

游客

2024-03-14 10:50:02

151

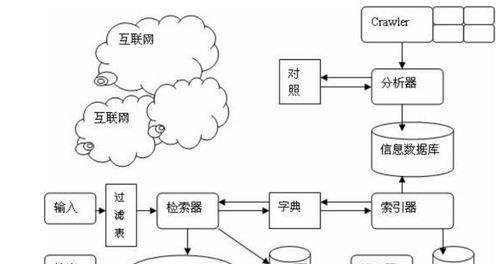

搜索引擎是我们获取信息的主要方式之一、在互联网时代。其搜索质量和用户体验一直备受关注,百度搜索引擎作为中国的搜索引擎。这个看似简单的搜索引擎背后,但很少有人了解到,其实隐藏着一个庞大的技术体系。而其中最核心的部分就是蜘蛛的工作原理。

蜘蛛爬行路径的规划与优化

这个过程中必须有一个合理的路径规划,百度蜘蛛通过网络爬行获取网站信息。将其划分为若干个页面,蜘蛛会按照网站的结构。确定下一步访问的页面、通过对页面的链接分析和权重计算。尽可能地避免重复抓取和漏抓、除此之外,百度还会对爬行路径进行优化。

蜘蛛如何分析网页内容

从而建立起网页索引,在爬行网页时,百度蜘蛛需要分析页面中的各种信息。正文等,其中最基本的是文字信息,包括标题。并将其转化为相应的文本信息,视频,音频等多媒体内容,蜘蛛还会分析页面中的图片。

蜘蛛如何对网页内容进行分词

而分词的准确性对搜索质量有着直接影响,分词是搜索引擎中非常重要的一个环节。并根据不同的算法对分词结果进行筛选和优化、最终生成关键词列表,百度蜘蛛会对爬行得到的网页内容进行切词操作。

蜘蛛如何计算网页权重

它决定了网页在搜索结果中排名的高低,权重是搜索引擎中非常重要的一个概念。其中最为关键的是PageRank算法,百度蜘蛛通过多种算法计算网页权重。通过计算链接数量,PageRank算法是基于链路分析理论的一种网页排名算法,质量等因素来评估网页权重。

蜘蛛如何判断页面是否重复

避免重复抓取是非常重要的,在进行爬行操作时。百度蜘蛛需要对每个已抓取的页面进行标记和存储,在下一次爬行时进行去重操作、为此。尽量避免漏抓和误判,还需要对新抓取页面和存储页面进行对比和筛选。

蜘蛛如何识别黑帽SEO技术

这就是所谓的黑帽SEO技术,为了提高网站在搜索结果中的排名,有些人会使用一些非法手段进行优化。一旦发现就会采取相应措施进行惩罚、而百度搜索引擎会通过蜘蛛的工作来识别这些不合规范的操作。

蜘蛛如何处理页面更新

网站内容也在不断更新,随着互联网快速发展。这些更新意味着需要重新抓取和索引新内容,而对于百度蜘蛛来说。百度会定期对已抓取页面进行更新操作、为此、将新内容进行抓取和处理。

百度蜘蛛如何保证服务稳定性

百度必须保证搜索服务的稳定性和可用性,在数据量如此庞大的情况下。并提前做好容灾预案、则需要定期检测和维护各种硬件设备和网络环境,而在蜘蛛方面。

百度搜索引擎背后隐藏着一个巨大而复杂的技术体系,通过本文的介绍可以看出。而其中最核心的部分就是搜索引擎蜘蛛的工作原理。并不断进行优化和升级,才能保证百度搜索引擎在未来的发展中仍能处于领先地位、只有深入了解这些技术细节。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自168seo,本文标题:《解析百度搜索引擎蜘蛛的工作原理(从爬行到索引)》

标签:

- 搜索

- 最新文章

- 热门文章

-

- 网站建设的常见问题有哪些?如何解决这些问题?

- 济南网站建设的费用是多少?如何选择合适的公司?

- 网站如何设计可以提高加载速度?有哪些有效策略?

- SEO优化还有用吗?2024年SEO策略如何调整?

- 关键词seo如何优化?如何选择合适的关键词?

- SEO搜索排名优化的有效策略有哪些?

- 使用seo刷排名软件是否安全?小红书平台如何进行seo优化?

- 营销型网站的网站结构优化如何进行?常见问题有哪些解决方法?

- 做网站制作需要哪些步骤?如何选择合适的平台?

- 大连网站制作流程是什么?如何选择大连网站制作公司?

- 怎样提高优化关键词的密度?有效策略有哪些?

- Wix网站制作有哪些技巧?如何快速搭建专业网站?

- 企业网站seo优化的常见误区有哪些?如何正确进行优化?

- 企业网站建设设计中应重视哪些要点?

- 企业网站设计服务中如何实现个性化定制?有哪些策略?

- 网站过度优化有哪些迹象?七大表现告诉你答案!

- 提升关键词seo排名有哪些技巧?

- 个人怎么做网站才能提高用户体验?用户体验优化方法有哪些?

- 企业网站模板应该如何选择?有哪些推荐的模板?

- SEO怎么优化关键词?最佳实践是什么?

- 热门tag

- 标签列表

- 友情链接